不知道大家有没有发现一个现象,似乎从去年下半年开始,各大手机厂商都开始争相竞逐AI赛道了。从AI语音助手到AI拍照修图,再到AI通话摘要……可以说是迫不及待地想要将AI深度嵌入到大众日常生活中的每一寸缝隙之中。

某天,当你轻触屏幕,你的手机不再仅仅是响应你的指令,而是超前预测你的需求......是不是突然觉得有点钢铁侠的贾维斯那个味儿了。

以前我们总觉得“手机贾维斯”时代似乎还停留在纸上谈兵的阶段,距离实现还是有很长一段距离,但现在来看,AI手机似乎已经实实在在地步入了“人工智能化”时代。

在9月10日举办的2024苹果秋季新品发布会上,苹果除了推出iPhone 16全系列和其他几件硬件产品外,还着重介绍了“苹果智能”(Apple Intelligence),将于下月起随iOS 18.1、iPadOS 18.1和macOS Sequoia 15.1发布。苹果智能功能的Writing Tools可以对用户输入的文本进行改写、校对和摘要;可以录制音频,将其转写为文字和摘要;照片APP中可以使用自然语言搜索特定照片。还可以帮助用户精简通知,比如将用户收件箱内的邮件生成摘要;Siri也更加自然、灵活,与系统体验深度集成。这些要素在今年6月份的“全球开发者大会”(WWDC)上已有所提及。

虽然AI作为iPhone 16的大招,引起了无数果粉的讨论,但是马斯克却一直坚定地diss苹果AI不安全。

苹果AI保护用户隐私安全的背后有什么“大招”?

据介绍,Apple Intelligence是一项苹果与OpenAI深度合作的成果,Apple Intelligence的核心在于其强大的数据处理和情境感知能力。它不仅能够深入理解设备中的各类数据,包括照片、邮件、信息等,并据此为用户提供包括了智能助手、邮件摘要、图片修改、自动翻译等多项个性化智能服务。

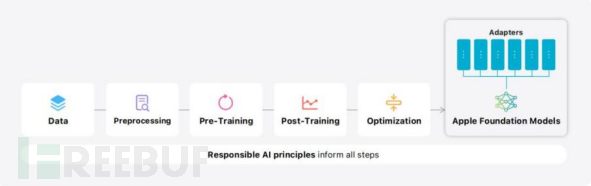

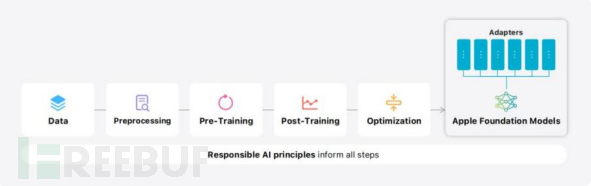

伴随 Apple Intelligence 上线 iOS 18、iPadOS 18 和 macOS Sequoia,苹果也发布了自家大模型的技术报告,并公布了大量技术细节,受到业界的广泛关注。

Apple Intelligence 包含了多个高效能的生成模型,它们快速、高效,专为用户日常任务而设计,并能即时适应用户当前的活动。构建到 Apple Intelligence 中的基础模型已经为用户体验进行了优化,如写作和润色文本、优先级排序和汇总通知、为与家人和朋友的对话创建有趣的图片,以及采取应用内操作以简化跨应用交互。

在技术报告中,苹果团队详细介绍了其中两个模型——一个约 30 亿参数的语言模型 AFM(Apple Foundation Model),以及一个更大的、基于服务器的 AFM-server 语言模型——是如何构建和适配的,从而高效、准确地执行专业任务。

而除了先进的AI技术以外,用户也开始担心个人信息是否会被泄露。这一矛盾使得苹果在开发新功能时,需要在技术创新与隐私保护之间找到一个平衡点。

对此,苹果伴随Apple Intelligence推出了私密云计算技术(Private Cloud Compute, PCC)。这一技术的核心在于如何在提升智能服务的同时,确保用户隐私得到有效保护。据悉,私密云计算允许在云端执行诸如邮件总结、图片生成等AI任务,而不必将用户数据暴露在风险之中。

苹果为私密云计算设计了专用服务器和定制化的操作系统,旨在为用户提供一个保护隐私的计算环境。不同于传统的私有云,私密云计算强调在数据处理过程中,始终保持用户信息的安全和隐私。苹果采取了“本地优先”的策略,优势主要在于用户更愿意将敏感数据,如影像、语音和邮件等交给端侧AI处理,不必担心数据被第三方缓存或泄露。

苹果高管克雷格·费德里吉表示,这项技术标志着云服务隐私保护的一个重大突破,目标是将iPhone本地的隐私保障体系扩展到云端。该技术通过减少数据持久性存储,确保每一次服务器重启后,数据都不会被保留。服务器配置精简,内置苹果专用的硬件加密管理器,随机生成的加密密钥加强了数据的安全性。

这种设计不仅消除了多种可能的攻击面,也为用户提供了一种全新的隐私保障体验。即便是需要云端处理的复杂任务,苹果也有一整套加密和隔离技术来确保用户的信息不会被泄露,主要有以下几个:

硬件安全模块 (Hardware Security Modules, HSMs):在需要与云端交互时,苹果的 iCloud 数据也经过复杂的加密处理。苹果使用 HSMs 存储和管理密钥,确保即便云端被攻击,用户的数据依然安全。

数据加密:苹果设备上的数据在存储和传输时会进行加密。比如在 iPhone 上,文件和数据库都会自动进行硬件级加密,使用的是AES (Advanced Encryption Standard) 256 位加密算法。用户数据即使被窃取,也无法被解读,除非拥有解密密钥。

安全隔区 (Secure Enclave):iPhone 和其他苹果设备中的 Secure Enclave 是一个特殊的处理器区域,专门用来处理敏感信息,如指纹、面容 ID 和密码。这一部分数据不会直接进入主系统,避免被恶意软件或应用访问。

差分隐私 (Differential Privacy):苹果在部分场景中使用差分隐私技术,即在收集数据前对其进行随机化处理,使得即使苹果获取了一些数据,也难以将这些数据与特定用户关联。

端到端加密 (End-to-End Encryption):苹果的 iMessage 和 FaceTime 通信服务采用端到端加密,确保数据在发送方和接收方之间传输时都被加密,任何中间节点包括苹果本身都无法解读这些通信内容。

隐私隔离 (Privacy Isolation):应用程序运行在受控的沙盒环境中,无法访问超出其权限的系统数据,苹果通过这类隔离措施来防止恶意应用侵入用户数据。

同时,苹果还采取了一些额外的措施来保护用户隐私,比如模糊用户的IP地址和MAC地址,防止应用通过这些数据来追踪用户。简单来说,苹果可以把用户的一些网络身份信息“隐藏”起来,让应用很难知道用户和数据的具体信息。

苹果试图保护用户隐私,但却被马斯克疯狂diss

但尽管苹果针对Apple Intelligence提出了诸多技术措施,也一再强调将用户隐私摆在首位,仍然没能消除外界对于隐私数据安全外泄的担忧。用户普遍担心,智能移动设备所带来的更加定制化、智能化的功能,以及更加“聪明贴心”的服务,是否意味着会收集更多的用户信息?苹果又是否真的能100%确保收集来的用户信息不外泄?这些忧虑也让不少人在“到底要不要尝试AI手机”这个问题的答案上反复横跳。

大家的担心也并非没有道理,因为即使苹果用心为iPhone打造了一套安全保险体系,一旦有第三方应用接入,隐私的那道防线就可能不再牢固。

但是接入三方应用存在风险问题不可避免,是所有用户面临的共同考验。这里隐私安全责任其实不主在苹果,属于用户和第三方应用之间的权责关系。

事实上,关于Apple Intelligence第三方应用可能牵扯到用户隐私安全的问题,前一阵子就已经闹得沸沸扬扬。起因是埃隆·马斯克对Apple Intelligence的发布表示了强烈的质疑和不满。他在X平台上连发多条推文,指责苹果“出卖用户数据”,并威胁说要禁止旗下公司使用苹果设备。

图片来源:X平台

马斯克认为,苹果不够聪明,无法自主开发AI,却表示能够确保OpenAI可以保护用户的安全和隐私,这显然是荒谬的。他还表示,一旦用户将自己的数据交给OpenAI,苹果也不知道将来会发生什么,他们这么做完全是在出卖用户。

的确,不同数据提供商的隐私政策如何保持一致性,是需要监管机构加强管理的方向。

例如iPhone允许接入像OpenAI这样的第三方大模型服务,用户在访问时可能没有意识到某些请求已被发送到OpenAI的GPT产品,可能导致敏感信息泄露。用户以为操作是在本地进行,但实际上这些查询请求已被转发到云端。

而且,OpenAI等第三方的用户数据处理并不受苹果监管,用户可能误以为数据由苹果全程保护,实际数据已被第三方处理,并遵循第三方的隐私政策,这些政策可能比苹果的宽松,这都是潜在的风险。

不止苹果,全球AI手机都正面临同样的安全风险

根据Canalys的数据,2024年,全球16%的智能手机出货量为AI手机,到2028年,这一比例预计将激增至54%。可见AI手机的快速发展已经成为全球智能手机市场的重要趋势。

放眼国内,在当前人工智能蓬勃发展的背景下,各大厂商均已拉起自身的AI移动端产品线。去年8月,华为宣布HarmonyOS 4系统全面接入盘古大模型;随后,小米则训练出轻量级语言大模型,参数规模为13亿和60亿两种;同年11月,vivoX100系列手机也首次搭载了自研vivo蓝心大模型......

据IDC统计,中国AI手机出货量预计在2027年达到1.5亿部,市场渗透率将超过50%。这一增长趋势表明,中国市场对AI手机的需求也在迅速攀升,而用户量的激增也意味着,AI手机安全问题迫在眉睫,亟待引起重视。

其实苹果目前面临的安全问题也正是全球其他所有AI手机同样面临的安全问题。比如:

AI手机搭载的AI大模型系统在训练和推理过程中需大量收集用户个人信息和敏感数据,一旦数据泄露或不当使用可能引发隐私保护问题,影响用户信任度和企业声誉。

同时,AI手机还可能生成或传播不适当、不准确甚至有害的内容,对用户造成不良影响。

攻击者还可能会通过AI手机的安全漏洞窃取用户敏感信息,如API安全漏洞,这可能引发用户数据泄露,对用户的隐私构成威胁。甚至可能会提取到AI手机内包括模型的权重、算法参数或训练数据,从而窃取专有AI模型的核心技术等等。

不过所幸到目前为止,还没有发生影响广泛的AI手机安全事件,并没有给用户造成困扰。这些安全问题仍停留在“潜在风险”的阶段。

不过,究竟该如何在AI技术的广泛应用与用户隐私保护之间找到微妙的平衡,是AI手机厂商需要持续思考的课题。

技术、法规双管齐下,或是AI手机安全“解药”

随着AI技术的快速发展,越来越多的AI应用被集成到智能手机中。而智能手机也无可厚非地成为我们生活中不可或缺的一部分,但无论如何以牺牲自己的隐私为代价换取便利的做法都是不可取的。那么面对如今AI手机可能带来的一系列安全威胁,是否有什么策略能够“对症下药”?

首先肯定是基于数据层面所制定的法律法规,因为这对所有相关涉及的企业均有所约束。

目前来看,与AI安全相关的法律法规有欧盟的GDPR、美国的CCPA、中国的《数据安全法》《网络安全法》和《个人信息保护法》,这些法律都涵盖了数据安全和个人信息保护,各类AI手机等移动设备均受其管辖。此外,还有AI隐私相关的规定,比如2023年中国发布的生成式人工智能服务管理暂行办法;2024年欧盟发布的人工智能法案以及人工智能与人权、民主和法治框架公约,其中涉及57个国家参与,重点关注AI风险和安全问题,包括数据安全和隐私保护。

不过综合来看,目前全球法律对这个领域的安全要求各不相同,如果未来针对此出台全球通用的法规,并设计数据安全基线,确定一些通用的服务能力,或将能有效推动科技创新。

另外,新兴的技术手段也或将为AI安全提供更多“捷径”。比如,量子计算能够提供基于量子密钥分发(QKD)的通信安全技术,这种技术可以监测试图窃取数据的黑客,从而保护AI手机中的数据不被未授权。此外,量子通信网络使用量子物理学原理,使得信息在传输过程中无法被入侵,这对于AI手机来说是一个巨大的安全优势。虽然目前还暂未有太多实际结合的应用,但是这的确为AI安全提供了新思路。

参考资料:

https://www.thepaper.cn/newsDetail_forward_28262512

https://baijiahao.baidu.com/s?id=1810868235082638284&wfr=spider&for=pc